Tematem mojego wystąpienia będzie relacja między informacją i entropią a kontekstem – rzeczywistość po komercjalizacji GPT-4 (dużego multimodalnego modelu językowego opublikowanego przez OpenAI w marcu br.). Zaczniemy od „powrotu do cybernetyki”, której twórca Norbert Wiener przestrzegał: „Cybernetyka to broń obosieczna i prędzej czy później zada wam głębokie rany”. Do cybernetyki warto w istocie wrócić, bo to ona sama powróciła. Współczesny kontekst cybernetycznych „obrazów-obiektów” (na przykład automatycznej fabryki opisanej przez Wienera) ma niewiele wspólnego ze sposobem produkcji nauki i techniki tuż po II wojnie światowej. Niemniej projektowane przez cybernetyków „obrazy-obiekty” stały się konkretne i dały maszyny, których działanie mogłoby wykraczać poza granice cybernetycznej wyobraźni: magazyny Amazona, autonomiczne pojazdy czy właśnie GPT-4. Odnośnie do tego ostatniego, będę przekonywał, że ten „generatywny i wstępnie wytrenowany transformer” to wstępnie wytrenowany generator entropii: informacyjnej i społecznej, a także entropii psychicznej w rozumieniu zaproponowanym przez psychiatrę Antoniego Kępińskiego. Aby jednak te entropie dostrzec i prawidłowo opisać mechanizmy ich generacji, trzeba poddać krytycznej rewizji interpretację entropii w teorii informacji i obliczeniowe wyjaśnienie umysłu jako właściwości mózgu polegającej na przetwarzaniu informacji. Postaram się pokazać, co taka interwencja teoretyczna nam daje i do czego mogłaby posłużyć w praktyce.

Wykład

Wstępnie wytrenowane generatory entropii

Uczestnicy

-

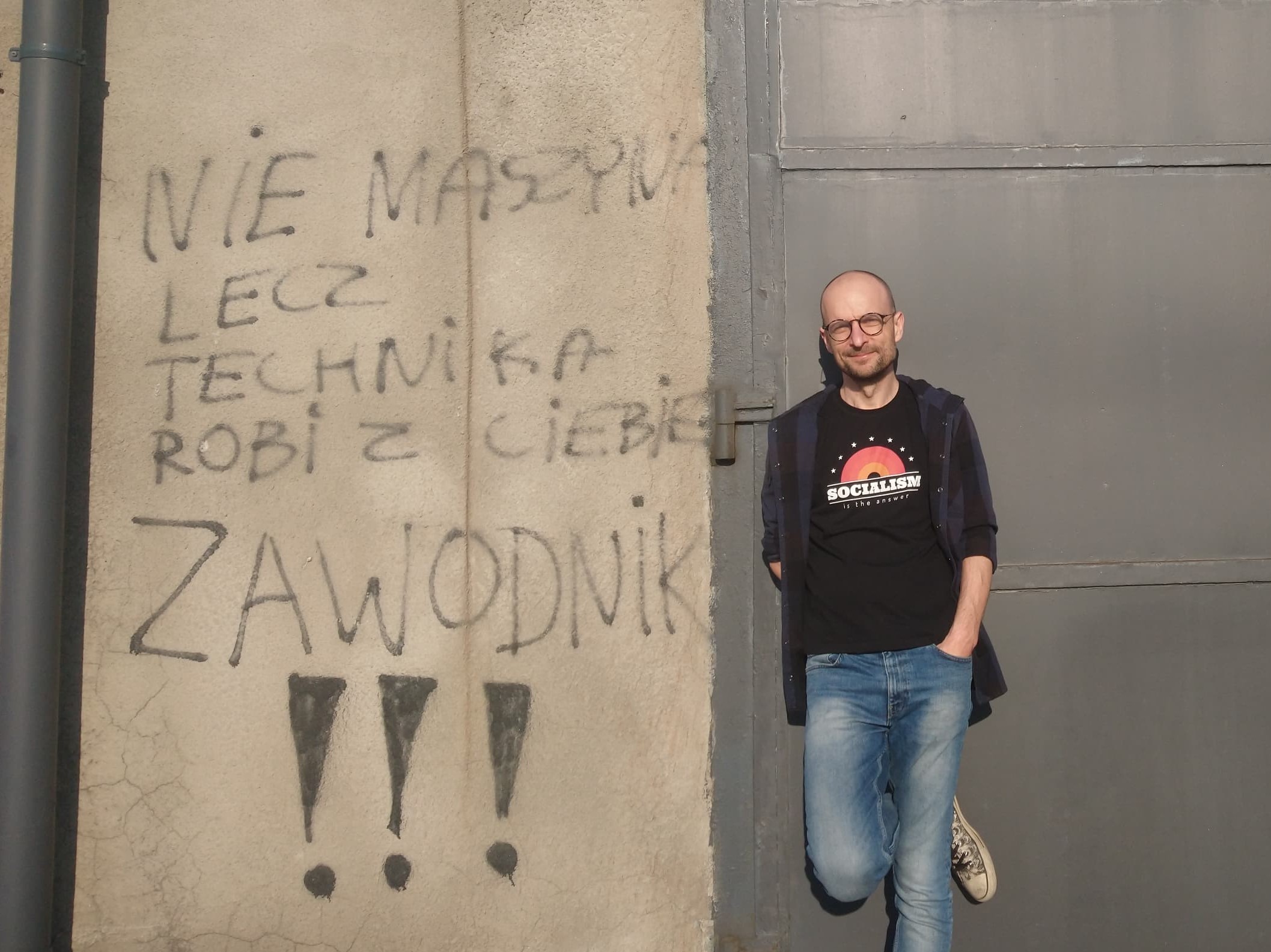

Michał KrzykawskiMichał Krzykawski

Michał KrzykawskiMichał KrzykawskiMichał Krzykawski

Prof. UŚ, filozof, literaturoznawca romański, wykładowca Uniwersytetu Śląskiego, gdzie kieruje Centrum Badań Krytycznych nad Technologiami. Autor wielu prac poświęconych współczesnej filozofii francuskiej, filozofii techniki, filozofii nauki i ekonomii politycznej w kontekście antropocenu. Współtwórca książki Bifurquer. «Il n’y a pas d’alternative» pod redakcją Bernarda Stieglera i kolektywu Internacja (Paris 2020; tłumaczenie angielskie w przygotowaniu). Współzałożyciel kolektywu Organoesis.

Wstępnie wytrenowane generatory entropii